Новая версия машинного интеллекта Libratus, выигравшего почти два миллиона долларов при игре в покер два года назад, смогла победить сразу пять чемпионов в эту карточную игру, игравших с ней за одним столом. Об этом пишут ее создатели в журнале Science.

"Игра сразу с пятью партнерами, а не с одним соперником, потребовала фундаментальных изменений в том, как ИИ вырабатывал свою стратегию. Мы рады тому, что Pluribus удалось справиться с этой задачей и выработать несколько инновационных приемов, которые, скорее всего, поменяют то, как играют профессионалы", — заявил Ной Браун (Noam Brown) из университета Карнеги-Меллон в Питтсбурге (США).

За последние три года программисты и математики совершили настоящий прорыв в области создания систем искусственного разума, превосходящих человека в умении играть в определенные стратегические и азартные игры.

К примеру, два года назад ученые создали ИИ AlphaGo, способный играть в древнекитайскую стратегию го лучше чемпионов Европы и мира. В этом году они представили ее новую версию, способную играть в любые настольные игры и компьютерный шутер Quake III Arena.

Помимо го, системам ИИ покорилась еще одна сверхсложная игра – покер. В марте 2016 года канадские программисты из университета Альберты создали искусственный разум DeepStack, способный играть в одну из простейших версий покера. Ему удалось стать победителем в высокоуровневом международном турнире, который проводился под эгидой Международной федерации покера.

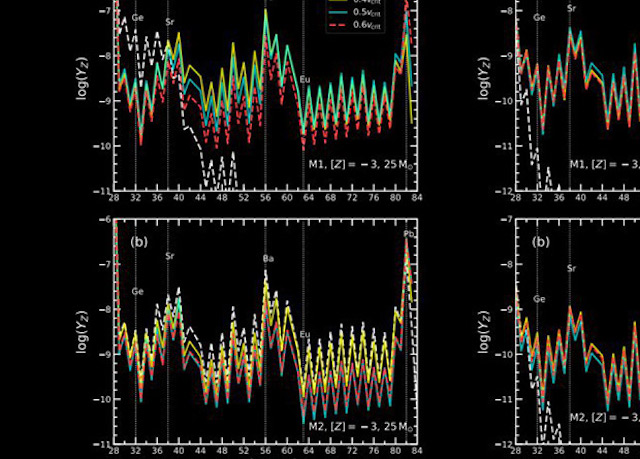

Два года назад Браун и его коллега Туомас Сандхольм (Tuomas Sandholm) создали систему Libratus, которая умеет очень хорошо играть в покер и при этом "мыслить абстрактно" – находить общие черты в различных комбинациях карт, ставок и прочих элементов игры, и считать их примерно одним и тем же вариантом развития событий.

Это значительно упростило ее работу и позволило ей победить ведущих игроков в "техасский холдем", самый популярный вид покера, заработав на турнире почти два миллиона долларов. Сандхольм и Браун не остановились на этом и создали новую версию этой машины, Pluribus, способную играть в "полноценный" покер.

Дело в том, что Libratus не был приспособлен для игры за столом вместе с пятью-шестью другими игроками, как это обычно происходит в казино – он учился игре, разыгрывая партии с копией самого себя. Как знают все любители карт, расширение числа игроков с двух до трех радикально меняет многие игры, в том числе и покер, что заставило ученых задуматься о том, как можно обучить этому их детище.

Для решения этой задачи ученые кардинально переработали логику работы и обучения новой версии искусственного интеллекта, сделав ее еще более абстрактной и встроив в нее систему, которую математики называют "минимизацией сожалений". Под этим выражением ученые понимают процесс, в рамках которого машина вычисляет разницу между принятым ей решением и оптимальной стратегией действий и пытается уменьшить это значение.

Подобное расширение Libratus, как отмечают исследователи, не только позволило новой версии этой системы, Pluribus, играть сразу с несколькими противниками, но и резко уменьшило нагрузку на

компьютеры.

В частности, на весь процесс ее тренировки до сверхчеловеческого уровня ученые потратили лишь 150 долларов США, арендовав небольшое вычислительное "облако" всего на неделю. Вдобавок, в прошлом работа этой системы в режиме реального времени была возможной только на суперкомпьютере, тогда как сейчас ее можно запустить на мощном "бытовом" ПК с 28-ядерным процессором.

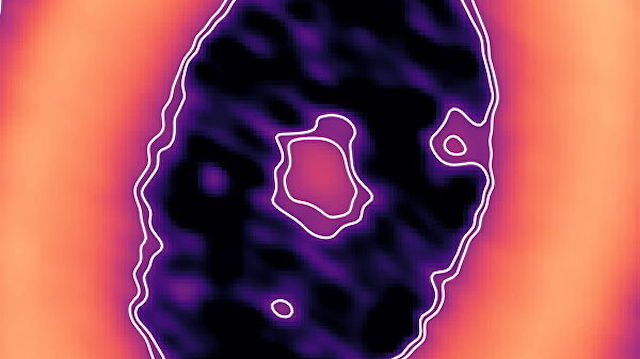

Работу Pluribus ученые проверили, заручившись поддержкой дюжины ведущих игроков, готовившихся к проведению очередной Мировой серии покера. В их число вошли Джейсон Лес, Дон Ким, Дэниэл Макоули и Джимми Чоу, уже игравшие с Libratus. Каждый из них выиграл более миллиона долларов за свою карьеру и неоднократно побеждал на десятках международных турниров.

Как и его предшественник, новая версия ИИ уверенно обыграла все людей, победив текущего чемпиона, Даррена Элиаса(Darren Elias), и заработав свыше 500 тысяч долларов за десять тысяч партий. При этом машинный интеллект выработал несколько парадоксальных или просто любопытных стратегий, которые люди в прошлом никогда не использовали или считали изначально проигрышными.

"Главный плюс Pluribus – умение комбинировать разные стратегии. Это то, чего пытаются добиться многие игроки в покер. Мало у кого получается менять их случайным образом, но при этом оставаться в плюсе. Почти все люди не могут справиться с этой задачей", — поделился впечатлениями Элиас.

Успешная игра Pluribus, как считают ученые, говорит о том, что искусственный интеллект в ближайшее время освоит и другие игры, в которых участвует больше двух игроков, а также научится решать другие задачи, в которых нет четких критериев победы или поражения.

По информации https://ria.ru/20190711/1556439144.html

�