Редактор журнала Scientific American Джордж Массер — о том, почему модели ИИ, обученные повторять, как попугаи, тексты из интернета, оказываются способны решать совершенно новые для них и весьма продвинутые задачи.

Никто не может сейчас сказать, как изменится мир с распространением ChatGPT и других чат-ботов на основе искусственного интеллекта, поскольку никто на самом деле не знает, что происходит у них внутри. Возможности подобных систем выходят далеко за рамки того, чему их обучали, и даже их разработчики не могут понять, почему. Все большее число тестов показывает, что системы искусственного интеллекта создают внутри себя модели реального мира так же, как это делает человеческий мозг, только технология у машин иная.

«Все наши попытки усовершенствовать их, сделать безопаснее и тому подобное кажутся мне смешными. Что мы можем сделать, если мы не понимаем, как они работают?» — говорит Элли Павлик из Университета Брауна. Она принадлежит к числу тех исследователей, которые пытаются восполнить этот недостаток знания.

До определенной степени она с коллегами понимает принцип работы и GPT (generative pre-trained transformer, генеративный предварительно обученный трансформер), и других LLM (Large Language Models, большие языковые модели). Эти модели основаны на системе машинного обучения, называемой нейронной сетью. Такие сети имеют структуру, организованную по образцу связанных между собой нейронов человеческого мозга. Код этих программ относительно прост и занимает всего несколько экранов. Он устанавливает алгоритм автокоррекции, который выбирает самое подходящее слово для завершения некоторой фразы на основе кропотливого статистического анализа сотен гигабайт интернет-текстов. Дополнительное обучение позволяет системе представлять результаты в форме диалога. В этом смысле все, что она делает, — извергает то, что в нее заложили. Это «стохастический попугай», по выражению Эмили Бендер, лингвиста из Вашингтонского университета. Но при этом LLM удалось сдать экзамен на адвоката, написать сонет о бозоне Хиггса, признаться в любви одному из своих собеседников и даже попытаться принудить его к разводу. Мало кто ожидал, что простой алгоритм автокоррекции обретет такие разносторонние способности.

Тот факт, что GPT и другие системы искусственного интеллекта выполняют задачи, к которым их не готовили, проявляя свои «новоприобретенные способности», впечатлил даже тех исследователей, которые прежде не разделяли восторгов по поводу LLM. «Я не знаю, как это у них получается, и насколько их способ действий похож на человеческий, но они заставили меня пересмотреть мои взгляды», — говорит Мелани Митчелл, эксперт по ИИ из Института Санта-Фе.

«Это, конечно, нечто большее, чем стохастический попугай, и он, конечно, создает внутри себя некоторое представление о мире — но я не думаю, что это похоже на то, как это делают люди», — говорит Йошуа Бенджио, исследователь ИИ в Монреальском университете.

На конференции в Нью-Йорке в этом году философ из Колумбийского университета Рафаэль Мильер привел еще один поразительный пример того, на что способны LLM. Они уже демонстрировали умение писать компьютерный код, что, конечно, производит впечатление, но не сказать чтобы сильное, поскольку в Интернете достаточно кодов, которые можно сымитировать. Но Мильер пошел дальше. Он показал, что GPT может также выполнять код. Философ ввел программу для вычисления 83-го числа Фибоначчи. «Это многоэтапное действие очень высокого уровня», — говорит он. И бот справился с задачей. Но когда Мильер запросил 83-е число Фибоначчи напрямую, GPT ошиблась, а это значит, что система не просто копирует интернет. Скорее всего модель производила собственные вычисления, чтобы получить ответ.

LLM работает на компьютере, однако сама языковая модель это не компьютер. Ей недостает некоторых важных элементов, в частности оперативной памяти. По сути косвенно признавая, что GPT сама по себе не способна запускать код, ее разработчик, технологическая компания OpenAI, представила специализированный плагин (инструмент, который ChatGPT может использовать при ответе на определенные запросы), позволяющий ей это делать. Однако этот плагин не использовался в эксперименте Мильера. Поэтому он выдвигает гипотезу, что машина сымпровизировала память, используя ее механизмы для интерпретации слов в соответствии с контекстом. Подобно тому, как природа переназначает уже наличествующие способности для выполнения новых функций.

Это непредвиденное умение говорит о том, что LLM развивают внутреннюю сложность, которая не ограничивается поверхностным статистическим анализом. Эти системы, похоже, начинают по-настоящему осознавать то, чему они научились. Для одного из исследований докторант Кеннет Ли из Гарвардского университета и его коллеги-специалисты по ИИ создали свою собственную уменьшенную копию нейронной сети GPT, чтобы изучить ее внутреннюю работу. Они тренировали ее на миллионах партий настольной игры illustration demonstrating the capabilities of ChatGPT in online courses and distance learning.illustration demonstrating the capabilities of ChatGPT in online courses and distance learning.«Отелло» (разновидность «Реверси») путем представления в текстовой форме длинных последовательностей ходов. Их модель стала почти идеальным игроком.

Чтобы понять, как нейронная сеть кодирует информацию, они применили метод, разработанный в 2016 году Йошуа Бенджио и Гийомом Аленом из Монреальского университета. Команда создала миниатюрную «зондовую» сеть, которая анализировала основную сеть слой за слоем. Ли сравнивает этот подход с методами нейробиологии. «Это как поместить исследовательский зонд в человеческий мозг», — говорит он. В случае с ИИ исследование показало, что хотя систему учили прогнозировать только следующий ход, ее «нейронная активность» простиралась на все игровое поле, представленное, правда, в несколько искаженной форме. Чтобы убедиться в этом, исследователи нарушали ход игры, внедряя информацию в сеть, — например, переворачивали одну из черных фишек белой стороной вверх. И сеть соответствующим образом корректировала свои действия. «По сути, мы взламывали мозг этих языковых моделей», — говорит Ли. Исследователи пришли к выводу, что ИИ играл, в общем, как человек: держал игровое поле перед «мысленным взором» и использовал его образ для выбора следующего хода. По мнению Ли, система вырабатывает такой навык потому, что это самая экономичная форма для обучающих данных. «При наличии большого количества игровых сценариев лучший способ сжать их — постараться найти общее правило, которое лежит в их основе», — добавляет Ли.

Эта способность делать выводы о структуре внешнего мира касается не только расположения фишек в играх; она также проявляется в диалогах. Группа исследователей из Массачусетского технологического института изучала сети, играющие в текстовые приключенческие игры. Вводились такие предложения, как «Ключ в сундуке с сокровищами», «Вы берете ключ». С помощью зонда было установлено, что сети кодировали внутри себя переменные, соответствующие словам «сундук» и «вы», каждая из которых имела свойство обладать или не обладать ключом, и корректировали эти переменные с каждым новым предложением. У системы не было возможностей узнать, что такое сундук или ключ, но она уяснила концепции, необходимые для выполнения задачи. «Внутри модели имеется некоторое представление о состоянии», — говорит Белинда Ли из группы исследователей.

Можно только удивляться, как много информации LLM способны выуживать из текстов. Например, Элли Павлик и ее аспирантка Рома Патель обнаружили, что сети черпают в интернете описания цветов и создают свои внутренние представления о них. Когда они видят слово «красный», они воспринимают его не просто как абстрактный символ, а как понятие, имеющее отношение к бордовому, малиновому, фуксии, ржавчине и так далее. Продемонстрировать это было довольно трудно. Вместо того, чтобы помещать в сеть зонд, исследователи изучили ее реакцию на серию текстовых запросов. Чтобы проверить, не являются ли ее представления простым повторением цветовых отношений из онлайн-источников, они попытались ввести систему в заблуждение, сообщив ей, что красный на самом деле является зеленым. Система в ответ не стала транслировать устаревшую информацию, а должным образом пересмотрела соответствия между цветами и объектами.

Развивая идею о том, что для осуществления самокоррекции система ищет логику, лежащую в основе ее обучающих данных, исследователь в области машинного обучения Себастьен Бюбек из Microsoft Research предполагает, что чем шире поток этих данных, тем более общие правила система в них обнаруживает. «Возможно, мы наблюдаем такой технологический рывок потому, что при нынешнем разнообразии данных основополагающим принципом может быть только то, что их создали разумные существа, — говорит он. — И [у модели] есть только один способ объяснить все эти данные — стать разумной».

Однако LLM не только познают глубинные смыслы языка, но и учатся по ходу дела. В области искусственного интеллекта термин «обучение» обычно означает интенсивный процесс, в рамках которого разработчики прогоняют через нейронную сеть гигабайты данных и настраивают ее внутренние связи. Прежде чем пользователь начнет вводить в ChatGPT запросы, все эти процессы должны быть закончены; в отличие от человека, языковой модели не следует продолжать обучение. Поэтому для специалистов стало неожиданностью, что LLM совершенствуются, используя подсказки пользователей, — такая способность известна как контекстное обучение. «Это другой вид обучения, о нем никто даже не подозревал», — говорит Бен Герцель, основатель ИИ-компании SingularityNET.

Один из примеров того, как обучается LLM, вытекает из способа, которым люди взаимодействуют с чат-ботами типа ChatGPT. Системе можно дать понять, как вы хотите, чтобы она общалась с вами, и она подчинится. Ее реплики составляются из нескольких тысяч слов, которые она видела последними. Как использовать эти слова, предписывается ей фиксированными внутренними связями, но некоторая вариативность тем не менее предполагается. Целые веб-сайты посвящаются подсказкам, как «взломать» систему, — преодолеть ограничения, не позволяющие ей рассказывать пользователям, например, как сделать бомбу, — обычно путем подачи указания притвориться системой без ограничений. Кто-то производит взлом в корыстных целях, кто-то для получения более мудреных ответов. «Модель ответит на сложные вопросы, так сказать, лучше, чем если бы ее просто спросили напрямую, без подсказки о взломе», — говорит Уильям Хан, содиректор Лаборатории машинного восприятия и когнитивной робототехники Флоридского атлантического университета.

Другой тип контекстного обучения осуществляется посредством подсказок по цепочке рассуждений. Сеть просят проговаривать каждый шаг своих рассуждений — такая тактика позволяет успешнее решать логические и арифметические задачи, требующие нескольких шагов. (Пример Мильера особенно удивителен, поскольку сеть нашла число Фибоначчи без какой-либо подобной подготовки.)

В 2022 году команда Google Research и Швейцарского федерального технологического института в Цюрихе — Йоханнес фон Освальд, Эйвинд Никлассон, Этторе Рандаццо, Жуан Сакраменто, Александр Мордвинцев, Андрей Жмогинов и Макс Владимиров — показали, что контекстное обучение основано на том же алгоритме, что и стандартное обучение, известное как градиентный спуск. Эта процедура не была запрограммирована; система нашла ее самостоятельно. «Это, должно быть, приобретенный навык», — говорит Блез Агуэра-и-Аркас, вице-президент Google Research. Он считает, что у LLM могут быть и другие скрытые способности. «Каждый раз, когда мы проверяем их на наличие новой способности, которую можно количественно измерить, мы ее обнаруживаем», — говорит он.

У LLM еще достаточно много слепых пятен, не позволяющих квалифицировать эти модели как общий искусственный интеллект, или ОИИ (термин, обозначающий машину, которая поднимается до уровня возможностей мозга живых существ). GPT-4 иногда дает пристрастные ответы, иногда бывает подвержена галлюцинациям, то есть выдает за правду свои собственные фантазии. Галлюцинации могут иметь конкретные последствия для людей в реальном мире. Это уже вызывало проблемы. В одном случае GPT необоснованно обвинила профессора права в Калифорнии в сексуальных домогательствах к студенту. В подтверждение своих обвинений языковая модель даже процитировала новостную статью, которой на самом деле не существует. А некий житель Австралии планирует подать в суд на ChatGPT, потому что чат-бот объявил, что этот мужчина был якобы приговорен к тюремному заключению за получение взяток.

Вместе с тем новые способности языковых моделей позволяют исследователям предположить, что технологические компании ближе к созданию ОИИ, чем предполагали даже оптимисты. «Эти способности косвенно свидетельствует о том, что мы, вероятно, не так уж далеки от ОИИ», — заявил Бен Герцель на конференции по глубокому обучению во Флоридском атлантическом университете. Плагины OpenAI придали ChatGPT модульную архитектуру, отчасти напоминающую архитектуру человеческого мозга. «Объединение GPT-4 (последняя версия LLM, лежащая в основе ChatGPT) с различными плагинами может стать путем к специализации функций, похожей на человеческую», — говорит исследователь Массачусетского технологического института Анна Иванова.

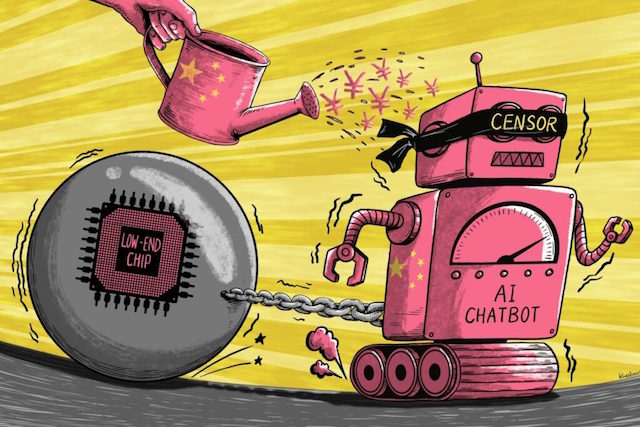

Однако исследователи обеспокоены тем, что могут лишиться возможности изучать эти системы. OpenAI не разглашает подробностей разработки и обучения GPT-4, в частности потому, что ей приходится конкурировать с Google и другими компаниями и странами. Это не только вредит исследованиям, но и препятствует пониманию социальных последствий внедрения ИИ. «Прозрачность этих моделей — самое важное условие обеспечения безопасности», — говорит Мелани Митчелл из Института Санта-Фе.

Немного ранее в этом году Илон Маск, Стив Возняк и ряд ведущих ученых в области ИИ (всего более тысячи человек) в открытом письме призвали к паузе в разработке ИИ, утверждая, что мощные системы следует развивать лишь тогда, когда есть уверенность, что последствия их внедрения будут положительными, а риски управляемыми. Эксперты по этике ИИ в ответ заметили, что подобные утверждения на самом деле только создают шумиху, приписывая технологиям сверхъестественную мощь. Они считают, что исследователям лучше просто сосредоточиться на решении текущих задач, например, повысить прозрачность обучающих данных, предоставлять четкую информацию о том, как галлюцинации влияют на надежность таких моделей, как GPT-4, и следить за тем, чтобы на модели, с которыми мы взаимодействуем напрямую, например ChatGPT или Bard от Google, перед публикацией устанавливались защитные ограничения.

По информации https://naked-science.ru/article/nakedscience/how-ai-knows

Обозрение "Terra & Comp".

�